趋境KTransformers+LLaMA-Factory,消费级显卡搞定千亿模型定制

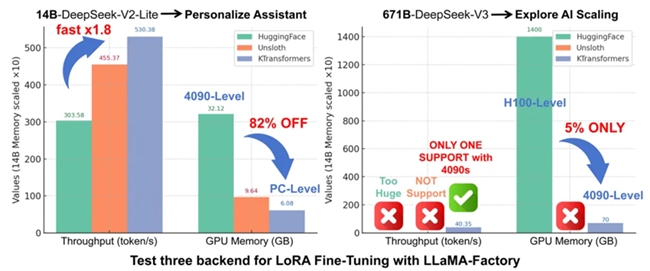

传统LoRA微调千亿模型的成本高达数百万,这让高校、中小型实验室、初创公司甚至个人开发者难以参与。而趋境科技KTransformers与LLaMA-Factory的深度集成,彻底改变了这一现状,为大模型微调提供了低成本、高效率的新选择。

该方案支持用户使用 LoRA 等轻量级微调方法,在极少量 GPU 资源下完成模型定制。经实测,仅占用约 41GB 显存,配合 2T 内存,就能实现 46.55 token/s 的微调吞吐量。对于开发者而言,操作流程也十分简便:只需同时安装KTransformers与LLaMA-Factory环境,配置好Kimi-K2的yaml文件并运行,即可启动微调任务。更关键的是,这是目前在消费级显卡上实现微调超大参数MoE模型的唯一可行方案。

在性能对比测试中,KTransformers微调方案优势显著。在较小规模的MoE模型(DeepSeek-14B)测试中,其吞吐速度超过传统方案1.8倍,显存占用较传统方案降低 82%。传统方案多依赖H100等高端 GPU,而KTransformers可支持4090级消费级显卡,大幅降低了硬件门槛。这一方案让创新门槛显著降低,学术研发领域能尝试更多样化的想法,企业应用层面可针对自身需求快速微调出定制化模型,且成本和周期大幅缩减,产品迭代更灵活高效

责任编辑:kj015

关键词:

武汉天佑之星儿童医院正规吗?

2025-11-20 17:44:06武汉天佑之星儿童医院正规吗?

11月22日/24日下午,重庆天佑儿童医院特邀重庆医科大学附属儿童医院黄志教授会诊

2025-11-20 17:11:5611月22日/24日下午,重庆天佑儿童医院特邀重庆医科大学附属儿童医院黄志教授会诊

随风寻梦天地,规划领航生涯

2025-11-20 16:48:05随风寻梦天地,规划领航生涯

视频剪辑培训机构哪家好?新达内教育,从0到1培养专业剪辑师

2025-11-20 16:37:02视频剪辑培训机构哪家好?新达内教育,从0到1培养专业剪辑师

从Web2到Web3,只差环球贸易网web3十万个为什么的距离

2025-11-20 16:10:51从Web2到Web3,只差环球贸易网web3十万个为什么的距离

看天津联合丽格邢莉莉院长详解窄双DO眼模版

2025-11-20 13:55:54看天津联合丽格邢莉莉院长详解窄双DO眼模版

相关新闻

2025-11-20 20:16:09

2025-11-20 20:15:51

2025-11-20 20:15:22

2025-11-20 19:52:37

2025-11-20 19:10:40

2025-11-20 19:10:22

2025-11-20 18:48:28

强强联手,共筑箱包产业数字新生态——中国大集、白沟和道国际、且力控股W2W战略合作正式启航

2025年11月18日,山东临沂——在数字经济与全球贸易格局深度重构的背景下,由临沂深度数科集团运营的"中国大集"平台、白沟和道国际箱包...

2025-11-20 18:27:52

家电推荐

家电图片

新闻排行

- 1

《工业与AI融合应用指南》全文发布, 提出“新六化”工业发展趋势和“三层五阶八步”实施方法

- 2

趋境KTransformers+LLaMA-Factory,消费级显卡搞定千亿模型定制

- 3

广东望京卡牌:精准工艺赋能品质定制 引领卡牌印刷裁切技术升级

- 4

2026翠鹿中国国际化学校竞争力排名发布 百万级数据支撑呈现教育格局新变化

- 5

硅臻首发基于硅光集成芯片的通用可编程量子计算机

- 6

新职业游戏陪练 成就青年就业新选择

- 7

汽车机器视觉龙头易思维科创板IPO:从国产替代到行业引领,布局全球化与新赛道,打造多元增长引擎

- 8

强强联手,共筑箱包产业数字新生态——中国大集、白沟和道国际、且力控股W2W战略合作正式启航

- 9

“百万”里挑一!扫描全能王、无限暖暖 、无畏契约入围苹果2025 App Store Awards中...

- 10

如何改善宠物毛发状态及应对宠物皮肤病