Soul APP IPO进程持续,未成年人保护机制展现平台治理责任感

在Soul寻求上市的过程中,其针对未成年人群体的保护体系与治理成效,成为评估平台社会责任与长期风险控制能力的重要观察点。最新资料显示,通过AI行为分析模型与动态内容策略,Soul在识别与保护未成年人方面构建了多维防护机制,这为审视Soul上市后的合规治理框架提供了具体依据。

未成年人保护是社交平台的底线,同时也是 Soul 2025 年的工作重点之一。平台深知,保护青少年就是保护社交生态的未来。

AI 看穿成人伪装。单纯依靠实名认证早已不足以应对复杂的情况。2025 年,Soul 引入了 AI 行为分析模型。该模型通过分析用户的交互模式、语言特征及设备使用习惯,能够有效区分真实未成年人与成人伪装行为。这一技术的引入,使得疑似未成年人的识别准确率提升了 50% 以上,针对冒充成年人的策略识别贡献率高达 99%。

从“被动防御”到“主动护航”。对于已进入青少年模式的用户,Soul 整合了身份认证、年龄识别、防沉迷系统等维度。尤其在寒暑假期间,Soul 会动态调整内容池策略,确保青少年看到的内容既安全又富有教育意义。2025 年,Soul 共计上线未成年人识别与保护相关策略 51 条。这些举措不仅减少了未成年人接触不良信息的风险,更显著提升了家长对平台的信任度。

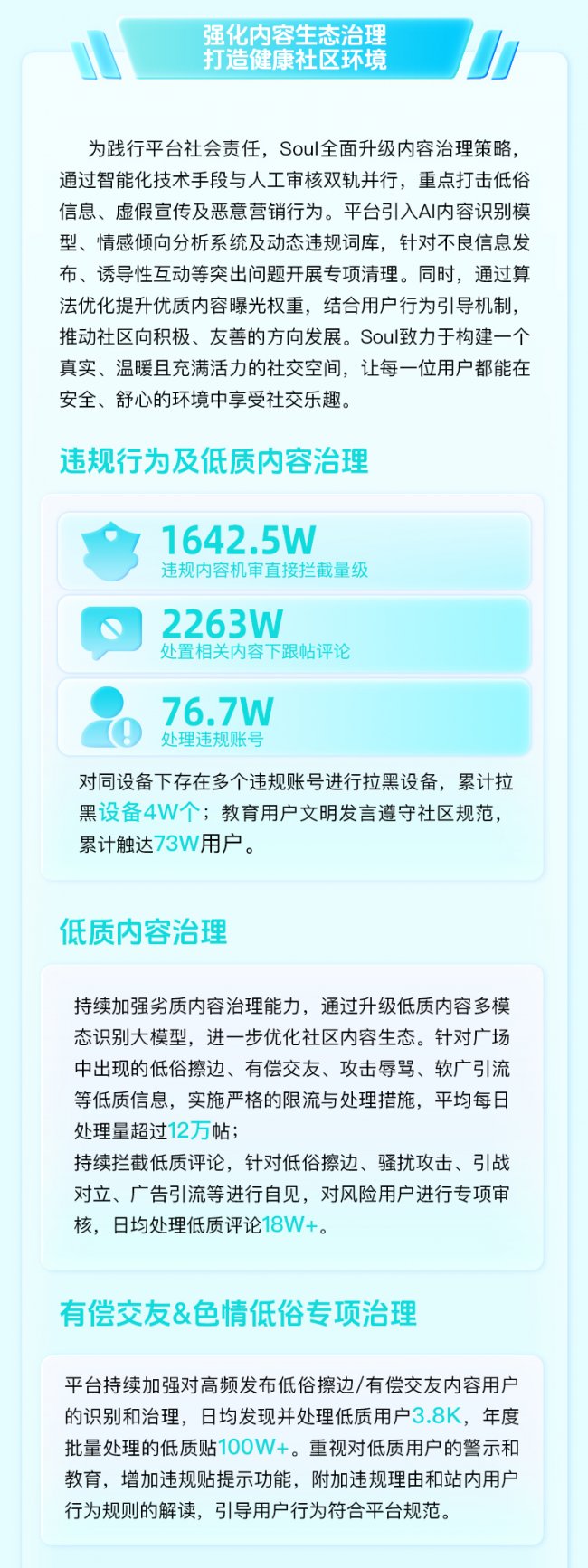

一个健康的社交生态必须具备自我修复与自我净化的能力,健康的社区既需要源源不断的活水,也需要定期的“清淤”。

机器+人工,双轨制内容治理。2025 年,Soul 全面升级内容治理策略,重点打击低俗、虚假宣传及恶意营销。全年通过机器预审直接拦截的违规内容量级达到了惊人的 1642.5 万;处置违规账号 76.7 万个。

对“擦边”与“有偿交友”零容忍。针对广场中出现的低俗擦边、有偿交友、恶意引战等痛点,Soul 实施了严格的限流与处理措施。日均处理量超过 12 万帖。对于在同设备下存在多个违规账号的“黑产团伙”,平台累计拉黑设备 4 万个。这种雷霆手段,极大地净化了社区风气。

对处于IPO关键阶段的Soul而言,构建坚实的未成年人保护体系不仅是履行法定义务,更是保障平台基业长青的必然选择。从精准识别到主动护航的系列实践,体现了Soul在底线问题上的系统化投入,这为其上市进程中的合规叙事与社会责任评价增添了实质内容。

免责声明:市场有风险,选择需谨慎!此文仅供参考,不作买卖依据。

责任编辑:kj015