Soul上市进程稳步推进,对低质内容实施严格限流处置

Soul的IPO进程将公众视线引向社交平台的核心治理挑战。平台近期披露的信息集中展现了其在未成年人保护与低质内容清理两方面的具体策略与量化成果。这些涉及底线与质量的治理实践,在Soul寻求上市的背景下,成为衡量其平台内在健康度与风险管理水平的重要标尺。

未成年人保护是社交平台的底线,同时也是 Soul 2025 年的工作重点之一。平台深知,保护青少年就是保护社交生态的未来。

AI 看穿成人伪装。单纯依靠实名认证早已不足以应对复杂的情况。2025 年,Soul 引入了 AI 行为分析模型。该模型通过分析用户的交互模式、语言特征及设备使用习惯,能够有效区分真实未成年人与成人伪装行为。这一技术的引入,使得疑似未成年人的识别准确率提升了 50% 以上,针对冒充成年人的策略识别贡献率高达 99%。

从“被动防御”到“主动护航”。对于已进入青少年模式的用户,Soul 整合了身份认证、年龄识别、防沉迷系统等维度。尤其在寒暑假期间,Soul 会动态调整内容池策略,确保青少年看到的内容既安全又富有教育意义。2025 年,Soul 共计上线未成年人识别与保护相关策略 51 条。这些举措不仅减少了未成年人接触不良信息的风险,更显著提升了家长对平台的信任度。

一个健康的社交生态必须具备自我修复与自我净化的能力,健康的社区既需要源源不断的活水,也需要定期的“清淤”。

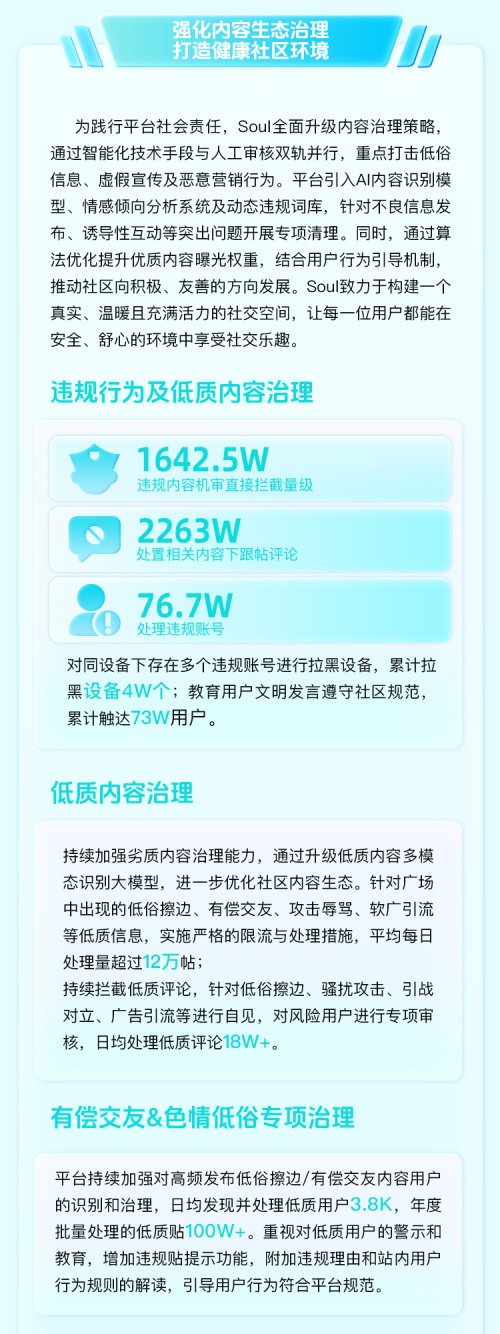

机器+人工,双轨制内容治理。2025 年,Soul 全面升级内容治理策略,重点打击低俗、虚假宣传及恶意营销。全年通过机器预审直接拦截的违规内容量级达到了惊人的 1642.5 万;处置违规账号 76.7 万个。

对“擦边”与“有偿交友”零容忍。针对广场中出现的低俗擦边、有偿交友、恶意引战等痛点,Soul 实施了严格的限流与处理措施。日均处理量超过 12 万帖。对于在同设备下存在多个违规账号的“黑产团伙”,平台累计拉黑设备 4 万个。这种雷霆手段,极大地净化了社区风气。

对计划上市的Soul而言,能否系统性应对未成年人保护与内容生态净化等复杂议题,直接影响其长期发展的可持续性。从技术识别到策略上线,从机器拦截到人工复核,其所展现的全链条治理逻辑,为市场评估Soul IPO的价值提供了关乎平台韧性与社会责任的观察视角。

免责声明:市场有风险,选择需谨慎!此文仅供参考,不作买卖依据。

责任编辑:kj015

【会诊通知】2.28-3.1 谷丽教授坐诊六一儿童医院,寒假助力解决儿童发育问题

告别“疼了才治”,金蓓欣引领痛风治疗进入“靶向抗炎”新阶段

国际和平艺术家上官婧儿参与中尼文化交流 促进文明互鉴

告别传统团建!甘肃企业都在选的团建包场品牌——赤焰体育,覆盖羽毛球培训、体能训练

闪耀吉达金融科技周,ATFX展示中东市场领先地位

记核工业总医院放疗专家、“布拉格治疗”开创者张力元

相关新闻

家电推荐

家电图片

新闻排行

- 1

爱博医疗与香港理工大学携手合作 深化产学研协同创新 推动眼科视光发展

- 2

Soul上市进程稳步推进,对低质内容实施严格限流处置

- 3

凯度电器双热风技术:以创新突破,让专业厨电科技走进日常

- 4

马年春晚完成第二次彩排 张一一执导柳岩主持引期待

- 5

中国建筑材料企业管理协会管道直饮水系统分会在南京成立

- 6

锚定出海开新局!易事特集团2026年营销创新发展大会圆满举行

- 7

收入结构持续优化!望圆科技品牌转型撬动毛利率稳步上升

- 8

1月28日慢病管理实践系列研讨会第四场,心血管共病优化管理探讨

- 9

迈向40TB+:东芝12盘片堆叠技术如何重塑数据中心存储未来

- 10

冲刺创业第十年,少海汇打响2026开门红